©

Foto: C. Wyrwa / Grafik: B. v. Knoblauch

©

Foto: C. Wyrwa / Grafik: B. v. Knoblauch

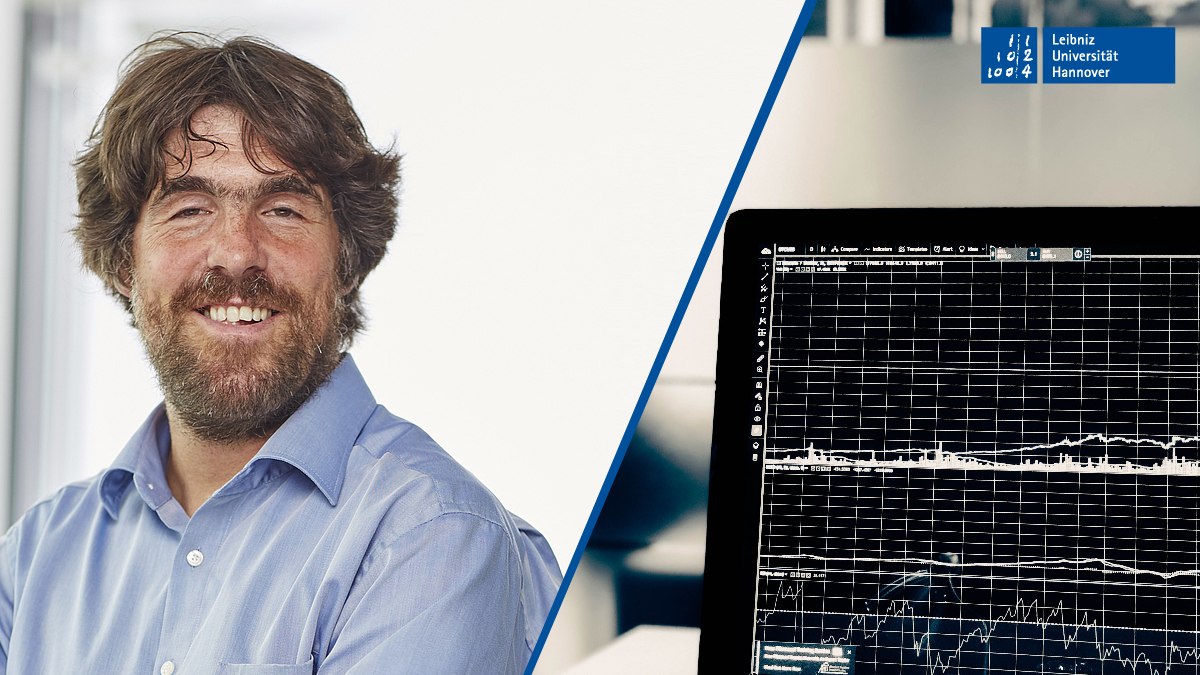

Wie lässt sich gesellschaftliches Vertrauen in die Wissenschaft stärken? Indem die Akteure über ihre Forschungsvorhaben, -methoden und -ergebnisse berichten. Im aktuellen Beitrag: Prof. Dr. Philipp Sibbertsen, Leiter des Instituts für Statistik der Leibniz Universität Hannover zum Projekt „Strukturbrüche in persistenten Zeitreihen“

Wie erklären Sie einem Laien den Kern und die Relevanz Ihres aktuellen Forschungsvorhabens?

In der heutigen Zeit werden Daten in einer unglaublichen Menge über alles Mögliche gesammelt. Immer mehr Entscheidungsprozesse in Unternehmen aber auch in der Politik hängen an Erkenntnissen, die aus diesen Daten gewonnen werden. Daher ist eine statistisch saubere und aussagekräftige Modellierung der Daten Grundlage vieler Entscheidungsprozesse.

Oft sind die Aussagen und Schlussfolgerungen, die aus den Daten gezogen werden können aber nicht eindeutig. Hier bedarf es dann neuer statistischer Verfahren, die zu einem besseren Verständnis der zur Verfügung stehenden Daten beitragen.

Mitglieder meines Institutsteams und ich haben vor gut sechs Jahren die Arbeit am Projekt „Strukturbrüche in persistenten Zeitreihen“ aufgenommen. Kern dieses Projektes ist die Identifizierung struktureller Veränderungen langfristiger Gleichgewichte in komplexen Datenstrukturen.

Wie lautet die Forschungsfrage für Ihr Projekt und welcher Methoden bedienen Sie sich?

Wir beschäftigen uns mit Fragen der statistischen Modellwahl. Häufig besteht bei der Datenanalyse für den Anwender das Problem der sogenannten Beobachtungsäquivalenz. Das heißt, dass die zur Verfügung stehenden Daten verschiedene Modellierungsansätze zulassen.

Der verwendete statistische Modellansatz wird einerseits benötigt, um grundlegende ökonomische Prozesse, die durch die beobachteten Daten beschrieben werden, besser zu verstehen. Zum anderen werden die statistischen Modelle auch für Prognosen verwendet. Für beides ist es wichtig, die Beobachtungen mit einem möglichst passenden statistischen Modell zu approximieren.

So können beispielsweise langfristige Änderungen in einem Gleichgewicht kaum von starken Abhängigkeiten der Beobachtungen untereinander unterschieden werden. Mit von uns entwickelten Methoden können wir dann zum Beispiel die Frage untersuchen, ob die Zinssätze von Staatsanleihen im Euroraum dauerhaft um ein langfristiges Gleichgewicht schwanken oder ob es Phasen gibt, in denen dieses Gleichgewicht eventuell nicht existiert und es somit keine Konvergenz der Zinssätze im Euroraum gibt. In der Tat können wir solche Phasen nachweisen.

Welche Ergebnisse und Anwendungsmöglichkeiten erwarten Sie?

Die Ergebnisse sind aus unserer Sicht die Entwicklung neuer statistischer Verfahren, die dann in möglichst vielfältigen Bereichen anwendbar sind. Die Palette der Anwendungsmöglichkeiten, die uns am Institut interessieren, ist sehr breit.

Neben Finanzmarktdaten und makroökonomischen Anwendungen lassen sich unsere Ergebnisse auch auf Fragestellungen aus dem Bereich der sogenannten „Climate Econometrics“ anwenden, da Klimadaten und geophysische Daten oft ähnliche Strukturen aufweisen wie ökonomische Daten. Konkret beschäftigen wir uns derzeit mit der Modellierung von Erosionen, die Stürme an Küstenlinien verursachen und der Modellierung von Regenfällen in verschiedenen Klimazonen. Auch hier geht es um die Erkennung von Instabilitäten langfristiger Mittelwerte beziehungsweise um die Modellierung extremer Ereignisse.

Mit welchen Mitteln finanzieren Sie Ihr Forschungsprojekt?

Neben den üblichen Universitätsmitteln bekommt das Institut für dieses Projekt Forschungsgelder von der Deutschen Forschungsgemeinschaft.

Welches Problem in Ihrem Forschungsalltag ließe sich nach Ihrer Meinung ohne Geld lösen?

In unserem Forschungsalltag ist vor allem der Zugang zu Daten sehr teuer. Die reine Entwicklung der statistischen Methoden ist ohne große Geldmittel möglich. Allerdings kommen die Ideen dafür, welche Verfahren benötigt werden und interessant sein könnten, oft aus der Betrachtung der Daten, so dass sich hier der Kreis wieder schließt.

In der wissenschaftlichen Praxis ist Versuch und Irrtum ein grundlegender Lern- und Erkenntnisprozess. Eine gesunde Fehlerkultur entlastet. Wir möchten daher Antworten auf die Frage „Was ist schiefgelaufen?“ veröffentlichen. Gibt es in Ihrer akademischen Laufbahn eine persönliche „Geschichte vom Scheitern“ und wenn ja, was können andere aus ihr lernen?

In der Tat gehören Fehler und Fehleinschätzungen zur Forschung dazu. Leider verfolgt man oft Ansätze, die sich dann als Sackgasse erweisen. Da man sich bei vielen Projekten aber auf Neuland begibt, ist das ein natürlicher Teil des Prozesses.

Ein für mich nachhaltiges Erlebnis hat eher etwas mit dem wissenschaftlichen Publikationsprozess zu tun. Wir hatten eine Arbeit eingereicht und mussten auf Verlangen der Gutachter in fünf Begutachtungsrunden zwölf Seiten an Beweisen nachreichen, was ein enormer Zeitaufwand war. Da einer der Gutachter die Arbeit aber offenbar prinzipiell nicht mochte, wurde sie dann nach der fünften Runde trotzdem abgelehnt. Als wir sie dann bei einem anderen, gleichwertigen Journal eingereicht haben, sagten die Gutachter, die vielen Beweise würden den Blick auf die Ideen verbauen. Nachdem wir alles wieder aus dem Papier herausgenommen hatten, wurde die Arbeit dann veröffentlicht. Mein Fazit: In diesem Prozess hängt vieles auch vom persönlichen Geschmack der Gutachter ab.

Vielen Dank für Ihre Auskünfte.

Die Fragen stellte Birgitt Baumann-Wohlfahrt.